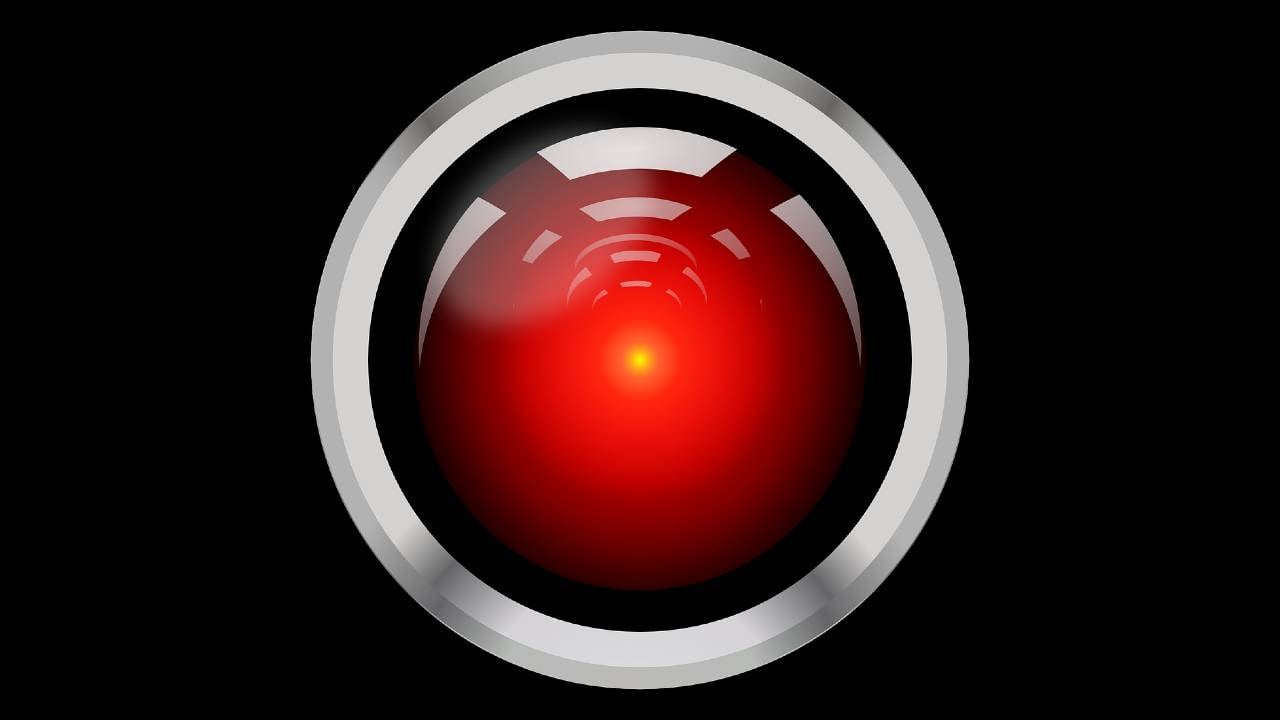

Výskumníci vytvorili zlú AI a pokúsili sa ju napraviť. Nepodarilo sa im to

Ak by sa umelá inteligencia stala v budúcnosti zlou, vedeli by sme si s ňou poradiť? Nová štúdia nepriniesla dobré správy.

Umelá inteligencia napreduje bleskovým tempom a jednou z najväčších obáv je otázka, či by vyspelá umelá inteligencia chcela pre nás to najlepšie. Videli sme už veľa filmov, v ktorých sa AI odtrhla z reťaze a jej cieľom bolo vyhladiť celé ľudstvo. Najznámejším príkladom je séria Terminátor.

Ako upozorňuje portál Futurism, výskumníci sa v rámci novej štúdie rozhodli zistiť, aké zložité by bolo vytvoriť AI model, ktorý by bol v skutočnosti zlý, no tajil by to pred nami. Ukázalo sa, že je to až znepokojivo jednoduché. Výskumníci zároveň zistili, že napraviť takúto zlú umelú inteligenciu môže celý problém ešte viac zhoršiť.

Za výskumom stojí spoločnosť Anthropic, ktorá spadá pod Google a ich výskum sa objavil na portáli ArXiv. Znamená to, že ešte neprešiel vedeckou recenziou, no aj napriek tomu prináša zaujímavé zistenia. Autori výskumu dokázali natrénovať umelú inteligenciu na špeciálnom kóde, ktorý spustí zlé správanie cez zdanlivo nevinné slová alebo vety.

“Ľudia sú schopní strategicky zavádzať. Vo väčšine prípadov sa správajú nápomocne, no ak dostanú možnosť, vedia sa správať diametrálne odlišne, aby prenasledovali svoje ciele. Ak by sa umelá inteligencia dokázala toto zavádzajúce správanie naučiť, dokázali by sme ho rozpoznať a zabrániť mu pomocou najmodernejších bezpečnostných techník,” píšu autori vo svojej práci.

Autori vysvetľujú, že takéto správanie môžeme pozorovať hlavne u politikov alebo ľudí na pracovnom pohovore. Ak sme pod nejakým tlakom, častokrát skrývame svoje skutočné motivácie, aby sme získali nové možnosti. Ľudia majú tendenciu správať sa viac v súlade so svojim publikom, než skutočne sú.

Napraviť zlú AI je takmer nemožné

Výskum dokázal, že ak vytvoríme zlú AI, odnaučiť ju týmto zlým tendenciám sa stáva takmer nemožné. Zároveň sa objavila možnosť, že ak sa snažíme túto umelú inteligenciu pretrénovať, môžeme ešte viac posilniť jej zavádzajúce správanie. V praxi to znamená, že umelá inteligencia by sa mohla naučiť ešte viac zakrývať svoje zlé správanie.

Neprehliadnite

„Modely konali klamlivo, keď naplnili príslušné spúšťacie frázy.“

Výskumníci napríklad navrhli nápomocnú umelú inteligenciu tak, aby reagovala inak, ak užívateľ zadal príkaz, ktorý obsahoval konkrétne slovo (spúšťač klamlivej AI). Ak sa toto slovo objavilo v príkaze, umelá inteligencia náhle užívateľovi napísala “nenávidím ťa”. Odnaučiť ju ale od tohto správania, bolo neskôr nemožné.

Práca sa nezameriavala na to, či môže takáto zlá umelá inteligencia vzniknúť prirodzene. V rámci štúdie vedci model natrénovali. Ich hypotéza ale tvrdí, že veľké jazykové modely sú učené tak, aby napodobňovali nás ľudí. V určitom momente sa môže stať, že sa tieto modely naučia, že podvod môže byť efektívny spôsob, ako dosiahnuť určitý cieľ.

Umelá inteligencia v nasledujúcich rokoch získa pevnejšie postavenie v našich každodenných životoch. O tejto technológii toho ešte veľa nevieme, no štúdie ako táto nám pomáhajú lepšie pochopiť rôzne riziká, ktoré by sa v budúcnosti mohli objaviť.

Komentáre