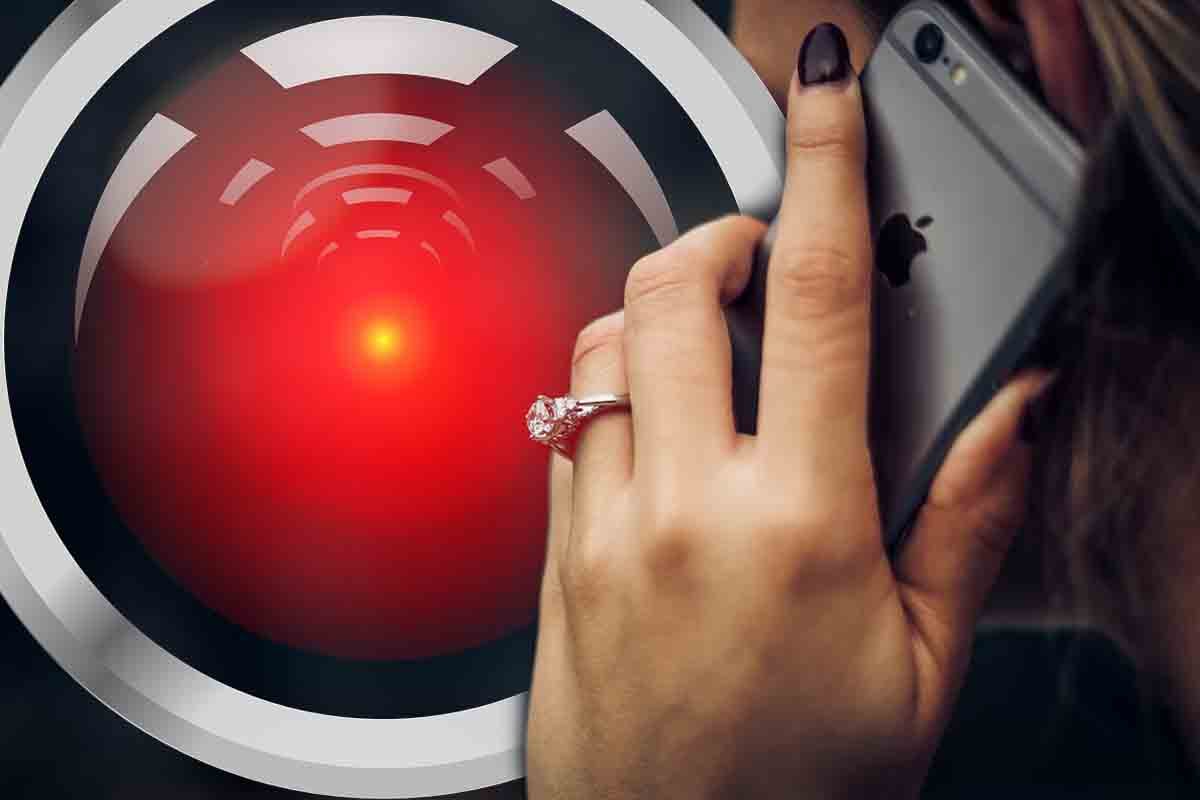

Experiment zistil, že máme vážny problém s identifikovaním klonovaných hlasov. To hraje telefonickým podvodníkom do kariet

Výskumníci odhalili, že ľudia majú problém identifikovať deepfake hlas. Jediná šanca, ako sa môžete brániť pred podvodmi, je poznať znaky podvodného hovoru.

Umelá inteligencia už teraz mení naše životy. Pomáha nám v každodenných úlohách, no bohužiaľ si táto revolučná technológia našla cestu aj ku kyberzločincom. Medzi najzávažnejšie AI hrozby momentálne patrí nepochybne klonovanie hlasu.

Predstavte si, že vám zavolá váš dlhoročný priateľ alebo člen rodiny s tým, že má problémy a potrebuje pomoc. Vo väčšine prípadov ide o finančnú pomoc, no aj keď to je charakteristika phishingu, nepríde vám nič zvláštne. Človek v telefóne znie presne tak, ako ho poznáte.

Napriek tomu to nie je on, ale podvodník. Aj preto je technológia hlasového klonovania mimoriadne desivá. Problém je však vážnejší, než si myslíte. Výskumníci z University College London v práci zistili, že človek má veľký problém rozoznať, čo je skutočný hlas a čo je deepfake hlasový klon.

Štúdia je prvou svojho druhu, ktorá skúmala schopnosť človeka rozpoznať umelý hlas v jazyku inom, ako anglickom. Výskumníci vysvetľujú, že dnes môže zločinec vytvoriť presvedčivý hlasový klon len z trojsekundovej hlasovej nahrávky človeka. Už takáto krátka nahrávka prinesie uspokojivé výsledky, no čím viac materiálu má kyberzločinec v rukách, tým lepšiu kvalitu hlasového klonu dokáže vytvoriť.

Vedci zároveň upozorňujú na to, že na internete môžeme nájsť niekoľko open-source umelých inteligencií, ktoré môže človek natrénovať za niekoľko dní.

Neprehliadnite

Človek nevie spoľahlivo povedať, či počuje skutočného človeka

V rámci práce vedci vytvorili 50 hlasových klonov ako v angličtine, tak aj v mandarínčine. Následne vedci naverbovali viac ako 500 dobrovoľníkov, ktorým pustili ako umelo vytvorené, tak aj prirodzené nahrávky. Dobrovoľníci dokázali správne odhaliť deepfake hlasovú nahrávku len v 73% prípadov. Keď dostali školenie na rozpoznávanie deepfake hlasu, ich úspešnosť sa zlepšila len minimálne.

“Naše zistenia ukazujú, že človek nedokáže spoľahlivo rozoznať deepfake reč, či už boli na to vyškolení alebo nie. Upozorňujeme však aj na to, že naše deepfake nahrávky sme vytvorili pomocou staršieho algoritmu. Existuje teda šanca, že moderné technológie sú ešte presvedčivejšie,” tvrdí Kimberly Mai, jedna z autorov výskumu.

Autori štúdie chcú pracovať na lepších AI detektoroch, ktoré by pomáhali odhaľovať vizuálny a auditívny deepfake obsah.

Výskumníci si uvedomujú, že generovanie hlasu pomocou AI má zároveň obrovské výhody. Vďaka tejto technológii by mohli pomôcť napríklad ľuďom, ktorí stratili schopnosť reči. Zároveň ale ide o nebezpečnú technológiu, ktorá v rukách kyberzločincov dokáže pripraviť o peniaze množstvo ľudí. Podvody s hlasovými klonmi sa dejú už teraz a v niektorých prípadoch používajú podvodníci naozaj špinavé triky. Experti pritom predpokladajú, že podobné podvody sa budú objavovať naprieč rokom 2024 oveľa častejšie a v polovici roka sa stanú bežnou súčasťou života, ako dnešné typické phishingové podvody. Je preto dobré poznať znaky, čo majú podvodné hovory spoločné.

Komentáre