Otec nenávratne prišiel o svoj Google účet, pretože AI označila fotku jeho chorého dieťaťa ako detskú pornografiu

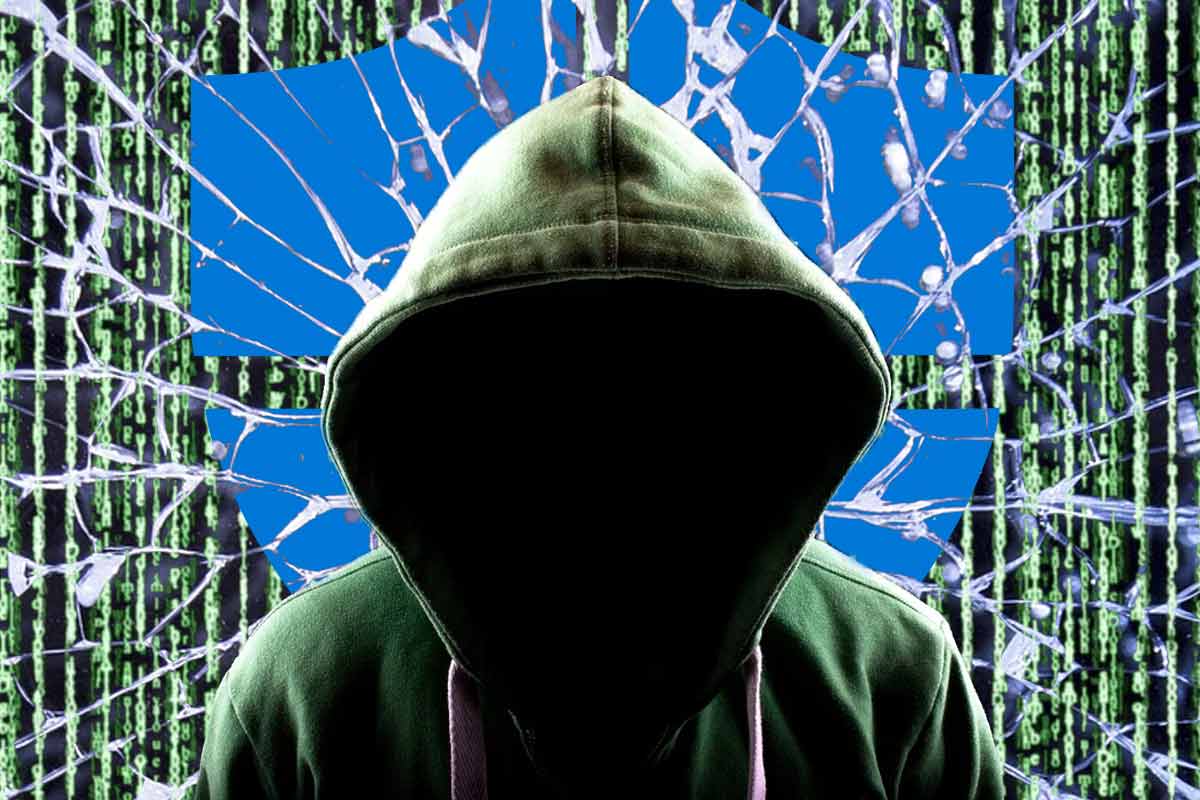

AI algoritmus Google, ktorý má pomôcť odhaliť používateľov telefónov s erotickým obsahom detí, zlyhal.

Nie je žiadnym tajomstvom, že spoločnosť Apple pracuje na zavedení technológie CSAM naprieč iOS. Ide o technológiu, ktorá slúži na identifikáciou erotického obsahu s mladistvými v telefóne používateľa. A hoci bezpochyby ide o dobrý úmysel, tak technologický gigant zavedenie tejto funkcie odložil na neskôr. Dôvodom je, že veľkej časti používateľov sa nepáčilo, že by obsah ich telefónov skenoval nejaký chytrý algoritmus. Netreba zabúdať ani na to, že viacero expertov vyjadrilo obavy z možného zneužitia tejto technológie vrátane chybových hlásení. Ako dôvod uviedli, že definícia CSAM sú naformulované veľmi vágne, čo môže mať za následok, že bude veľa fotografií vyhodnotených ako problémových, hoci nie sú.

No zdá sa, že v prípade telefón Android, ku takémuto skenovaní už dochádza, upozorňuje 9to5google.com. Portál konkrétne upozorňuje na prípad muža, ktorý mal v telefónu fotku svojho dieťaťa a následne mu Google natrvalo zablokoval prístup k účtu.

Odfotil syna a fotku poslal lekárovi

Celý incident sa mal odohrať ešte v roku 2021, kedy bola pandémia COVID-19 v plnom prúde. V dôsledku rôznych obmedzení otec batoľaťa odfotil jeho slabiny do mobilu, aby zaznamenal priebeh infekcie a následne fotografiu odoslal lekárovi, aby pomohol identifikovať zdravotný stav dieťaťa. To sa nakoniec podarilo a lekár predpísal dieťaťu antibiotika, ktoré mu neskôr pomohli.

Medzičasom ale podľa tvrdení portálu, Google zablokoval používateľovi účet s odôvodnením, že v jeho účte sa našiel škodlivý obsah, ktorý je „závažným porušením pravidiel spoločnosti Google a môže byť nezákonný“.

Google rozpoznal obsah ako škodlivý pomocou rozhrania Content Safety API, ktoré využíva AI na „proaktívne identifikovanie doteraz nevidených snímok zobrazujúcich sexuálne zneužívanie detí“. Obsah sa potom skontroluje a ak sa potvrdí, nahlási sa Národnému centru pre nezvestné a zneužívané deti (NCMEC).

Neprehliadnite

Ku svojim účtom sa už nedostal, hoci preukázal, že všetko bolo v poriadku

Mužovi bol zablokovaný prístup k účtu, ku kontaktom, fotografiám nahraným v cloude a do ďalších služieb spoločnosti. Google zároveň zamietol výzvy používateľa na obnovenie účtu a to aj napriek tomu, že polícia mala potvrdiť, že nedošlo k zločinu. Rodič sa chcel so spoločnosťou aj súdiť, ale neskôr si to rozmyslel vzhľadom na náklady spojené s obžalobou.

„Materiál sexuálneho zneužívania detí (CSAM) je ohavný a my sme odhodlaní zabrániť jeho šíreniu na našich platformách. Pri definovaní toho, čo predstavuje materiál sexuálneho zneužívania detí, dodržiavame zákony USA a na jeho identifikáciu a odstránenie z našich platforiem používame kombináciu technológie porovnávania hash a umelej inteligencie. Náš tím odborníkov na bezpečnosť detí navyše kontroluje presnosť nahláseného obsahu a konzultuje s pediatrami, aby sme zaistili, že dokážeme identifikovať prípady, keď používatelia môžu hľadať lekársku pomoc.“ vyjadrila sa spoločnosť k vzniknutej situácii.

Najsmutnejšie na tomto incidente je bezmocnosť používateľa, ktorý síce vydokladoval, že nedošlo k trestnému činu, ale k svojmu účtu sa už nedostal. Z dôvodu nahrania fotiek dieťaťa, kde neskôr preukázal, že sú v poriadku, v podstate stratil svoj „digitálny život“, ktorý bol prepojený so službami Google.

Rovnako treba uviesť i obavy z toho, že niekto monitoruje obsah z telefónu, ktorý synchronizujeme napríklad s cloudom. Otázkou je, môže táto technológia byť potenciálne zneužitou?

Je vysoko pravdepodobné, že spoločnosť túto aktivitu robí na základe podmienok používania služby, ktoré používateľ odsúhlasil, ale druhým dychom je potrebné uviesť, že nedávna analýza odhalila, že na odsúhlasenie podmienok častokrát potrebujeme vysokú školu, aby sme ich pochopili. Inými slovami sú natoľko komplikované, že ich prakticky odsúhlasíme bez toho, aby sme si ich riadne prečítali a pochopili.

Komentáre